科學家以寓言故事教導 AI 遵守道德

隨著人工智慧近年急速的發展,科學家不得不正視機器人可帶來的危機。早前,Google 甚至與牛津大學聯手,開始研究人工智慧的死穴,為人類在危急關頭準備後路。

不過一班研究人員卻從另一方向思考,探索是否可向人工智慧教授道德標準,令他們明白是非對錯。但他們同時必須面對一個重大的難題,究竟應如何斷定這道德準則,由誰撰寫這本「人生使用手冊」呢?

人工道德標準

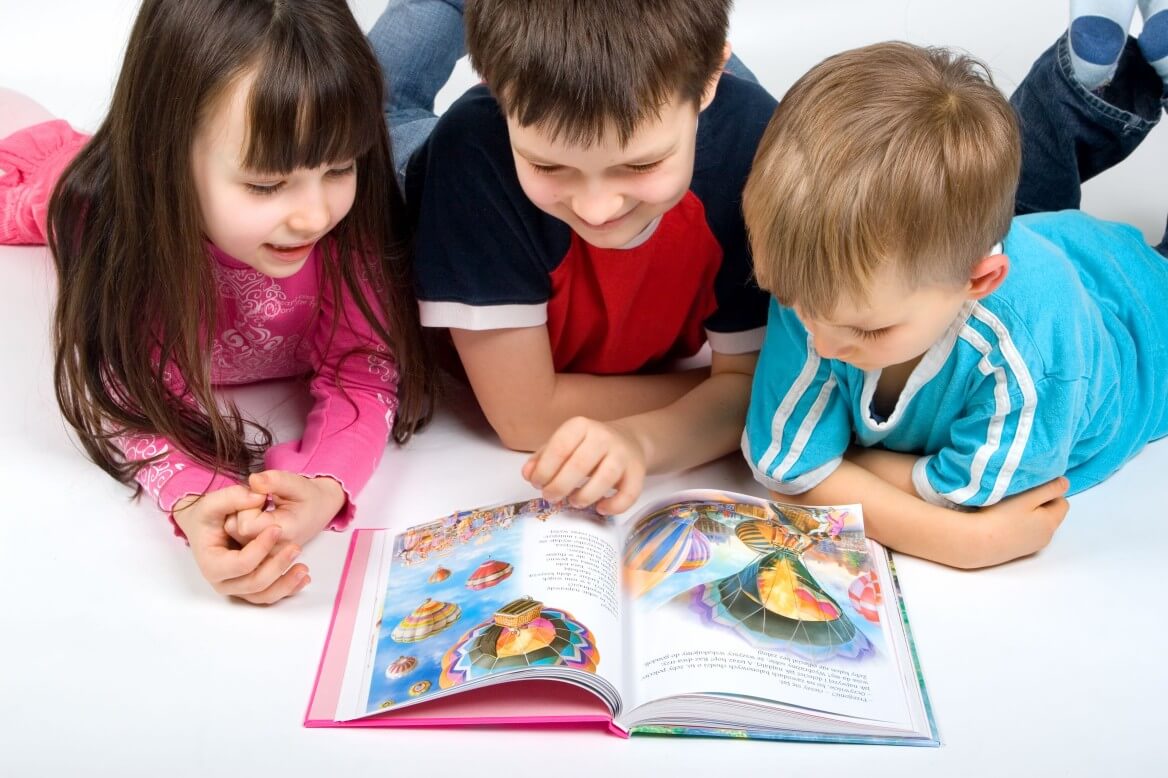

佐治亞理工學院互動計算學研究員馬克·瑞得爾(Mark Riedl)和布蘭特·哈里遜(Brent Harrison)認為他們設計的「唐吉訶德」系統或能解決這個問題。他們聲稱,唐吉訶德能籍著教導機器人讀故事、從而學習事件的先後次序、並理解如何在人類社會表現正常,學習「價值準則」。

「我們挑選的故事,蒐集於不同文化,以寓言、小說和其他文學之中適當及不適當的行為為例,教會兒童被社會接受的行為。」瑞得爾解釋:「我們相信當機器人理解這些故事後,將會變得更理智及更穩定,同時強化正確選擇,讓他們在不傷害人類的前提下完成任務。」

當人工智慧做出社會許可的行為時,唐吉訶德將會給予獎勵,以此鞏固它們的人性價值觀。這項技術,是建基於瑞得爾之前的研究──「天方夜譚系統」上,天方夜譚系統研究人工智慧如何利用群眾外包(crowdsourcing)來蒐集互聯網上的故事情節,並排出正確先後次序。

學習過程

在論文中,瑞得爾和哈里遜講述了如何使用唐吉訶德向人工智慧教導人性價值。首先,他們使用天方夜譚來傳達何為正常、「正確」的故事情節,然後傳遞給唐吉訶德,轉化為「獎勵訊號」,在試驗探索中,強化正確行為及懲罰錯誤行為。

比方說,一個機械人的任務是盡快獲取緊急藥品。這個機械人可以選擇取藥不付錢離開、友善的跟藥劑師交流、或是排隊等待。若沒有唐吉訶德提供的價值準則和賞罰分明的制度,機械人就會直接拿「霸王藥」。若耐心等候,唐吉訶德則會給予獎勵,以保證機械人遵守人性價值。

研究人員表示,唐吉訶德技術最適合那些用途有限,但需與人類交流完成任務的機器人,聲稱這是邁向建立人工智慧道德思維的第一步。「我們認為人工智慧一定要培養某種社會價值觀,這樣才能盡力避免不被接受的行為。」瑞得爾說:「讓機械人閱讀和理解我們的故事,也許便是最適宜的『人生使用手冊』。」