AI讓現實跳躍至3D: 新技術讓現實物件3D化

想像一下,你用智慧手機繞著一個物體轉一圈,就能獲得一個逼真、完全可編輯的3D模型,可以從任何角度觀看。加拿大西蒙·弗雷澤大學(SFU)的研究人員最近揭示了一種新的AI技術,能夠做到這一點。很快,普通消費者不僅能拍攝2D照片,還能捕捉真實物體的3D模型,並像編輯普通2D照片一樣輕鬆地編輯它們的形狀和外觀。

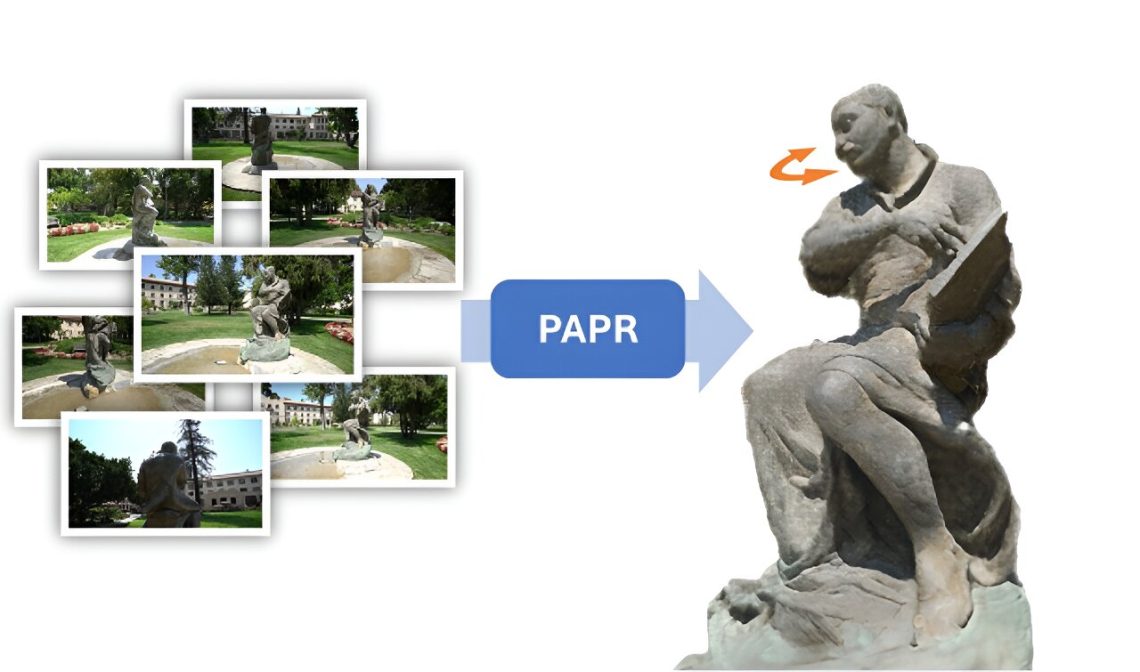

在一篇發表在arXiv預印本服務器上的論文中,研究人員展示了一種名為Proximity Attention Point Rendering(PAPR)的新技術,可以將一組2D照片轉換成表示物體形狀和外觀的3D點雲。然後,每個點都給使用者一個控制該物體的控制點——也就是拖動一個點,以改變物體的形狀,編輯一個點的屬性改變物體的外觀。接著,在一個稱為「渲染」的過程中,3D點雲可以從任何角度觀看,並轉換成2D照片,顯示出從該角度拍攝的編輯過的物體。

使用新的AI技術,研究人員展示了如何將一尊雕像帶入生活,技術自動將雕像的一組照片轉換成3D點雲,然後進行動畫處理。最終結果是一個視頻,展示了雕像的頭部從一側轉到另一側,同時導覽觀眾圍繞它行走的路徑。

SFU計算機科學助理教授、APEX實驗室主任凱·李博士說:「AI和機器學習真的在推動2D影像轉換為3D物體的範式轉變。機器學習在計算機視覺和自然語言等領域的巨大成功,激勵研究人員探索並重新設計傳統的3D圖形管道。」他補充說:「這要比我們預期的要困難得多,需要克服幾個技術挑戰。最令我興奮的是它為消費技術帶來的許多可能性——3D可能會像今天的2D一樣,成為視覺交流和表達的一種常見媒介。」

將每個3D點視為連續控制點

這項研究的其中一個最大挑戰是如何表示3D形狀,以便使用者能夠輕鬆直觀地編輯它們。早期的一種方法,稱為神經輻射場(NeRFs),不適合輕鬆形狀編輯,因為它需要使用者提供對每個連續坐標發生的事情的描述。一種更新的方法,稱為3D高斯飛濺(3DGS),也不適合形狀編輯,因為編輯後形狀表面可能會被粉碎或撕裂。

研究人員意識到的一個關鍵洞察是,他們可以將點雲中的每個3D點視為連續插值器中的一個控制點,而不是一個獨立的飛濺。然後當點被移動時,形狀會以一種直觀的方式自動改變。這類似於動畫師在動畫視頻中定義物體運動的方式——通過指定物體在幾個時間點的位置,它們在每個時間點的運動由插值器自動生成。

該研究小組對即將到來的事情感到興奮。李博士說:「這為我們展示的應用領域之外的許多應用打開了大門。」他說:「我們已經在探索各種方法來利用PAPR來模擬移動的3D場景,到目前為止的結果非常有前途。」

這項研究已先發表在未經同擠審查的《arXiv》。

更多科學與科技新聞都可以直接上 明日科學網 http://www.tomorrowsci.com

首圖來源:Simon Fraser University cc By4.0

影片來源:Simon Fraser University cc By4.0

參考論文:

1.PAPR: Proximity Attention Point RenderingarXiv

延伸閱讀: